Die Diskussion rund um KI hat sich von der anfänglichen Euphorie, hin zu einer differenzierten, datengestützten Analyse der tatsächlichen ökonomischen Effekte verschoben. Investoren, politische Entscheidungsträger und Unternehmensvertreter stehen vor der Herausforderung, zwischen spekulativen Hype-Zyklen und fundamentalen Produktivitätsverschiebungen zu unterscheiden. Die aktuelle Studienlage spricht eine klare Sprache: Ökonomen rund um den Globus sind sich einig, dass Künstliche Intelligenz das Potenzial hat, das weltweite Wachstum und die Produktivität in den nächsten Jahren substanziell positiv zu beeinflussen.

Wie stark diese positiven Effekte ausfallen und wer davon primär profitieren wird, hängt unter anderem davon ab, wie breit und effizient die Technologie implementiert wird. Hinzu kommen Vorbehalte bezüglich Implementierungskosten, Grenzen der Automatisierbarkeit komplexer Aufgaben sowie Verfügbarkeit der nötigen Inputfaktoren, namentlich der benötigten Energie. Rechenzentren benötigen einen hohen energetischen Input, um die gewünschte Rechenleistung zur Verfügung zu stellen.

Der Produktivitätsschub

Im Fokus der Debatte um die makroökonomischen Auswirkungen auf das Wirtschaftswachstum steht das Konzept der totalen Faktorproduktivität. Vereinfacht lässt sich die Wirtschaftsleistung (Output) in der folgenden Formel darstellen:

Y = A × Kα × Lβ

Dabei gilt:

Y = Output insgesamt

A = totale Faktorproduktivität

K = Produktionsfaktor Kapital

L = Produktionsfaktor Arbeit

α,β = jeweilige Outputelastizitäten der Faktoren K und L

Anhand dieses Modells lässt sich relativ einfach zeigen, dass ceteris paribus der Output insgesamt (Y) steigt, wenn die totale Faktorproduktivität (A) zunimmt.

Totale Faktorproduktivität (A, kurz: TFP) beschreibt, wie gut eine Volkswirtschaft ihre verfügbaren Produktionsmittel wie Arbeit und Kapital nutzt. Sie misst also nicht, wie viel Arbeit oder Kapital eingesetzt wird, sondern wie effizient damit gearbeitet wird. Steigt die totale Faktorproduktivität, kann mit denselben Ressourcen mehr produziert werden. Sie hängt unter anderem von Technik, Ausbildung, Organisation, Infrastruktur und verlässlichen Regeln ab.

Die Annahme, die nun im Zusammenhang mit KI getroffen werden kann, ist, dass der technologische Fortschritt die TFP erhöht und damit auch eine Steigerung des Outputs ermöglicht.

Die Modelle und ihre Annahmen

So intuitiv das beschriebene Modell und seine Auswirkungen auf das Wirtschaftswachstum sein mögen, so komplex präsentiert sich die Umsetzung bei der konkreten Modellierung. Wie üblich müssen unter hoher Unsicherheit verschiedene, teilweise interdependente Annahmen getroffen werden. Auf den Punkt bringt es ein Zitat, das Denkern wie Mark Twain, Winston Churchill und Niels Bohr zugeschrieben wird:

«Prognosen sind schwierig, insbesondere wenn sie die Zukunft betreffen.»

Das lässt sich alleine an der Vielfalt der Studienergebnisse ablesen, die in den letzten Monaten zu diesem Thema veröffentlicht wurden.

Wir machen folgende Feststellungen: 1. Die Tendenz ist positiv, das Ausmass ungewiss; 2. Es gibt zwei Lager: die Optimisten und die Konservativen. Zum Lager der Optimisten gehören tendenziell Analytiker aus der Privatwirtschaft (Banken, Beratungsunternehmen etc.). Dieses Lager dürfte unserer Ansicht nach zum Überschwang tendieren – berufsbedingt.

Die konservativen Stimmen kommen tendenziell aus dem akademischen Umfeld, das sich – ebenfalls berufsbedingt – wohl lieber in etwas stärkerer Zurückhaltung übt, um später positive Revisionen vorzunehmen, anstatt sich in der Zukunft Blauäugigkeit vorwerfen lassen zu müssen.

Einen Mittelweg gehen Institutionen wie der IWF oder die OECD, denen man eine gewisse Neutralität, ja gar eine vermittelnde Position zuschreiben könnte.

Die nachfolgende Tabelle zeigt die erwarteten Effekte, den Zeithorizont sowie Kernargument und Mechanismen einiger ausgewählter Studien zum Thema auf.

Quelle: Studien, Google Gemini, BLKB

Der J-Kurven-Effekt und das Tal der Enttäuschung

Dabei gilt es unserer Ansicht nach zu beachten, dass auch hier mit einem J-Kurven-Effekt zu rechnen ist. Dieser beschreibt den Verlauf der Profitabilität eines Investitionsvorhabens. Typisch ist hierbei, dass aufgrund der initial anfallenden Kosten bei fehlenden Erträgen am Anfang eine negative Entwicklung zu beobachten ist, bevor sich die Investition auszuzahlen beginnt. Überträgt man dieses Modell auf die aktuelle Debatte, so können die sog. Hyperscaler herangezogen werden. Google, Amazon, Meta und Co. tätigen heute grosse Investitionen in KI-Infrastruktur, in der Annahme, dass sich diese künftig in Mehreinnahmen niederschlagen werden. Wie hoch diese ausfallen werden, ist heute aber noch ungewiss. Wir gehen entsprechend davon aus, dass die Gewinne aus der Technologie sich erst später im Jahrzehnt materialisieren werden, während bereits heute enorme Investitionen getätigt werden müssen. Dies stellt die Akteure auf eine Geduldsprobe. Weitsicht und strategisches Vorgehen sind gefragt. Gemäss dem Gartner Hype Cycle Bericht 2025 hat generative KI das «Tal der Enttäuschung» (Trough of Disillusionment) erreicht. In dieser Phase weicht die anfängliche Begeisterung der Ernüchterung über die Komplexität der Integration.

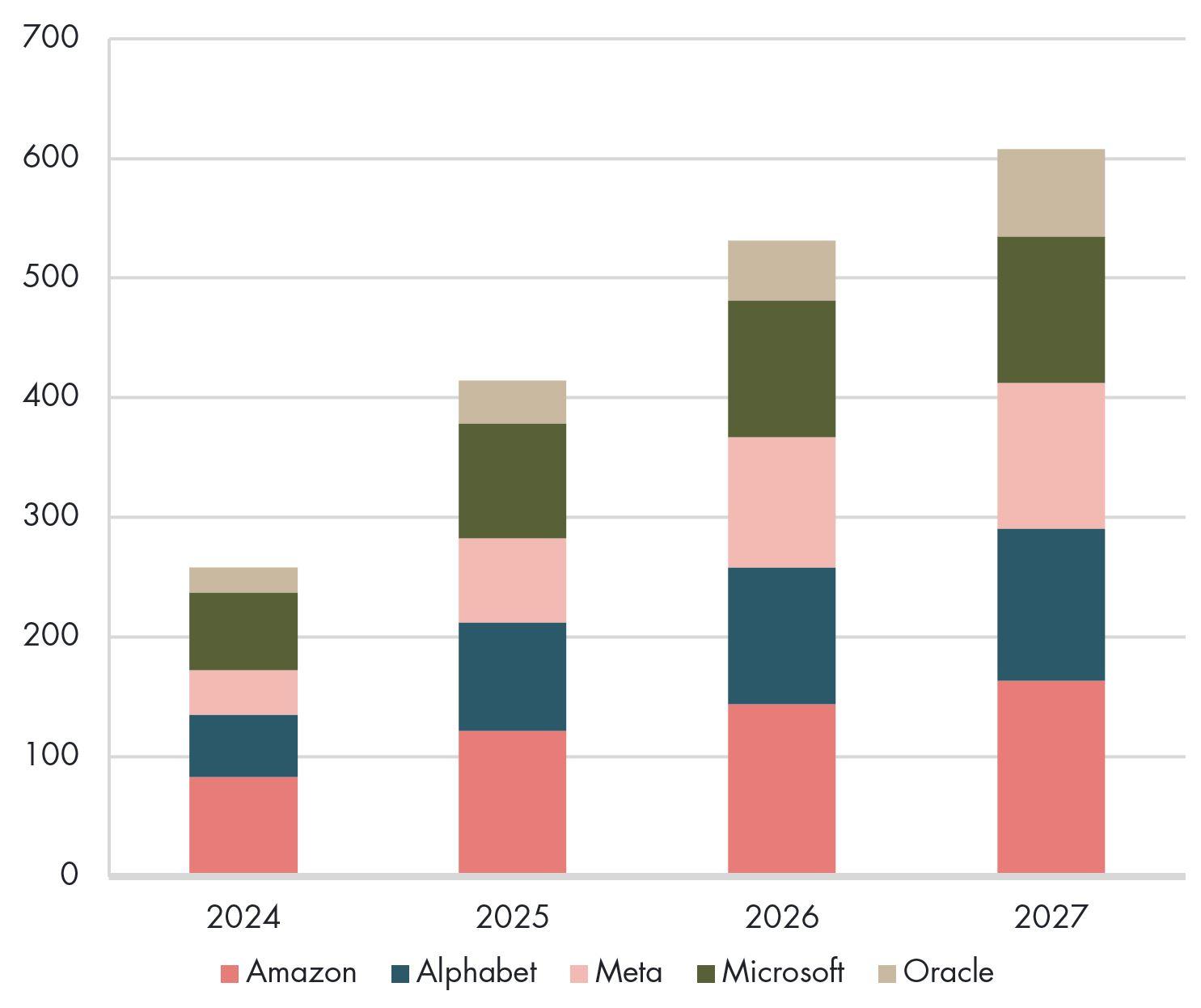

Allerdings bedeuten die angesprochenen Investitionen bereits heute einen greifbaren positiven Einfluss auf das Wirtschaftswachstum. Die nachfolgende Grafik zeigt die Kapitalinvestitionen der bedeutendsten Akteure in diesem Bereich sowie aktuelle Konsensschätzungen zum Verlauf der Ausgaben in den kommenden Jahren.

Capex-Pläne der Hyperscaler (in USD Mrd.)

Quelle: Unternehmensberichte, Bloomberg

Schätzungen zufolge haben KI-Investitionen im ersten Halbjahr 2025 rund einen Prozentpunkt zum Wirtschaftswachstum der Vereinigten Staaten beigetragen. Damit haben sie den Konsumenten (temporär) als wichtigste Wachstumssäule abgelöst.

Energiebedarf als kritischer Faktor

Zu den zentralen Hürden, vor denen die Technologie steht, zählt unserer Ansicht nach der enorme Energiebedarf. Der Energiehunger der Rechenzentren wird zunehmend zum makroökonomischen Faktor und gleichzeitig auch zum Politikum.

Prognosen der IEA zeigen, dass der weltweite Stromverbrauch von Rechenzentren sich bis 2030 etwa verdoppeln könnte – auf rund 900 bis 1000 TWh, was knapp 3% des globalen Stromverbrauchs entspräche. Wenn der zusätzliche Bedarf nicht mit erneuerbaren Energien gedeckt wird, steigen die CO₂-Emissionen, was es schwerer machen könnte, die Net-Zero-Ziele zu erreichen. Zu den Lösungsansätzen der Betreiber von Rechenzentren gehören heute eine Bandbreite von Dieselgeneratoren bis hin zu eigenen vor Ort installierten Kraftwerken.

Effekte werden je nach Sektor unterschiedlich ausfallen

Die Auswirkungen von künstlicher Intelligenz dürften nicht uniform über alle Branchen verteilt ausfallen. Aktuell wird mit einer K-förmigen Entwicklung gerechnet: Sektoren, die KI zur Optimierung physischer oder hochkomplexer Prozesse nutzen, erleben einen Boom. Branchen, deren Kernprodukt reine Information oder kreative Dienstleistung ist, stehen vor Disruptionen. Zu den Gewinnern dürften insbesondere wissens- und datenintensive Sektoren gehören, während bestimmte Routinetätigkeiten auf dem Prüfstand stehen.

Die nachfolgenden Analysen zeigen für einige ausgewählte Industrien auf, wie die KI-Wirkmechanismen ausfallen könnten und welches Potenzial, oder auch welche Fallstricke, sich daraus ergeben.

Gesundheitswesen

Konsumgüter

Industrie

Technologie, Medien & Telekommunikation

Finanzwerte

Diese Webseite enthält Werbung. Siehe Disclaimer.